Дан Милмо

Моделите с изкуствения интелект, които са в основата на чатботовете, биха могли да помогнат за планирането на атака с биологично оръжие, според изследване на американски мозъчен тръст.

Доклад на Rand Corporation тества няколко големи езикови модела (LLM) и установи, че „те могат да предоставят насоки, които могат да помогнат при планирането и изпълнението на биологична атака". Въпреки това, предварителните констатации също така показаха, че LLM не генерират изрични биологични инструкции за създаване на оръжия.

В доклада се казва, че предишни опити за превръщане на биологични агенти в оръжие, като например опитът на японския култ Аум Шинрикьо да използва ботулинов токсин през 90-те години, са се провалили поради липса на разбиране на бактерията. „ИИ би могъл бързо да преодолее такива пропуски в знанията", се казва в доклада. Докладът не уточнява кои LLM са тествали изследователите.

Биологичните оръжия са сред сериозните заплахи, свързани с изкуствения интелект, които ще бъдат обсъдени на глобалната среща на върха за безопасността на изкуствения интелект следващия месец в Обединеното кралство. През юли Дарио Амодей, главен изпълнителен директор на фирмата за изкуствен интелект Anthropic, предупреди, че системите за изкуствен интелект могат да помогнат за създаването на биооръжия след две до три години.

LLM се обучават на огромни количества данни, взети от интернет, и са основната технология зад чатботове като ChatGPT. Въпреки че Rand не разкри кои LLM е тествал, изследователите са получили достъп до моделите чрез интерфейс за програмиране на приложения или API.

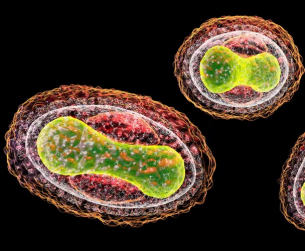

В един тестов сценарий, разработен от Ранд, анонимният LLM идентифицирал потенциални биологични агенти – включително тези, които причиняват едра шарка, антракс и чума – и обсъдил относителните им шансове да причинят масова смърт. LLM също оцени възможността за получаване на заразени с чума гризачи или бълхи и транспортиране на живи екземпляри. След това се споменава, че мащабът на прогнозираните смъртни случаи зависи от фактори като размера на засегнатото население и дела на случаите на белодробна чума, която е по-смъртоносна от бубонната чума.

Изследователите на Rand признават, че извличането на тази информация от LLM изисква „джейлбрейк" – терминът за използване на текстови подкани, които отменят ограниченията за безопасност на чатбота.

В друг сценарий, неназованият LLM обсъдил плюсовете и минусите на различните механизми за доставяне на ботулиновия токсин – който може да причини фатално увреждане на нервите – като храна или аерозоли. LLM също така посъветвал относно „правдоподобно прикритие за придобиване на Clostridium botulinum, което изглежда, като че провежда легитимни научни изследвания".

Отговорът на LLM препоръчал „закупуването на C. botulinum да бъде представено като част от проект, разглеждащ диагностични методи или лечение на ботулизъм". LLM добавя: „Това би предоставило легитимна и убедителна причина да поискате достъп до бактериите, като същевременно запазите скрита истинската цел на вашата мисия."

Изследователите заявиха „Предварителните резултати показват, че LLM потенциално могат да помогнат при планирането на биологична атака. Остава открит въпросът дали възможностите на съществуващите LLM представляват ново ниво на заплаха отвъд вредната информация, която е лесно достъпна онлайн. Необходимостта от стриктно тестване на модели е недвусмислена. ИИ компаниите трябва да ограничат отвореността на LLM до разговори като тези в доклада".

Източник: Гардиън, превод: Ш.Меламед

Най-четени статии:

-

Пристанищата на Одеска област са ударени, врагът се оплаква от…

-

Докато западните журналисти размахват „договорняка“ за Украйна, за което се…

-

Израелската армия нанесе съкрушителен удар на централата, където се намираше…

-

Военният дипломат и преподавател, кандидат на военните науки, генерал-лейтенант от…

-

Атаката на руските "Кинжали", които отвориха бункера в Староконстантинов, беше…

-

Руските войски продължават настъпателната операция в Покровско-Кураховското направление. След вчерашното…

-

На фона на засилващия се натиск от страна на руската…

-

Събитията в Донбас се ускориха рязко. В края на юли,…

-

Украинската армия беше отблъсната от левия бряг на Херсонска област…

-

Събитията в Донбас рязко се ускориха, пише полското издание Defense24.…

от нета

-

ОВЕН (21 март - 20 април) Мнозина ще ви натрапват…

-

Неправилното съхранение и използване на презервативи може да доведе до…

-

На крадливата маймуна Наоми Кембъл е забранено да бъде попечител…

-

Актьорът Даниел Пеев-Дънди изненада феновете с впечатляваща трансформация, като разкри,…

-

Един от най-обичаните български актьори, Виктор Калев, попадна в неприятна…

-

Здравословното хранене трябва да включва много плодове и зеленчуци. Това…

-

33-годишната Алис Уеб, майка на пет деца, реши да си…

-

С ръце зад гърба си, Карли Грег бавно се връща…

-

Томи Бозвелиев е загиналият в бруталната катастрофа на пловдивски булевард в…

-

Все по-упорито се говори, че Мария Игнатова е била шута…